Hacia la elucidación de las estructuras de las proteínas

La importancia de este conocimiento es enorme dado que las proteínas son las biomoléculas que dan la cara, los caballos de batalla de las células. Es decir, las moléculas que soportan las principales funciones de los seres vivos, las que determinan sus propiedades esenciales como son: dar soporte estructural a las células y tejidos, catalizar las reacciones que permiten el metabolismo del que depende la síntesis de todo tipo de moléculas, conformar los sistemas de defensa por medio de las reacciones antígeno-anticuerpo, etc. Sus errores, o los de los genes que determinan su estructura primaria, pueden dar lugar a numerosas patologías, u más raramente alguna ventaja funcional o estructural en el ser vivo en que suceden.

Una de las grandes preocupaciones de la investigación es la de conocer cómo se organizan y cómo se ensamblan los elementos más simples para conformar estructuras más complejas. Es la clave para entender la relación entre estructura y función, cuestión fundamental en Biología. Es a su vez la vía necesaria para conocer los efectos de sus alteraciones, el por qué falla algo que explica un cambio en el funcionamiento de un componente molecular, un error en una enzima, o en un componente estructural de una célula, etc., con enormes repercusiones en la investigación biomédica.

El conocer cómo están organizadas las moléculas es la clave para dar paso a la vertiente más espectacular y arriesgada de la biología molecular, la de la biotecnología. El poder diseñar moléculas con un previsible efecto sobre los organismos a los que se les proporcionan, con aplicaciones tan interesantes como el diseño de vacunas u otros fármacos, la síntesis de genomas artificiales, la transgénesis o, en general, la biología sintética.

Seguramente la revolución biotecnológica que ha desembocado en el momento actual tuvo lugar con tres significativos descubrimientos, relacionados con la idea de conocer detalles estructurales de las moléculas biológica más importantes, los ácidos nucléicos, el ADN, y las proteínas.

El primer gran paso lo dio el investigador inglés Frederick Sanger con su método de degradación secuencial y análisis cromatográfico de la estructura primaria de la insulina humana, por el que recibió su primer premio Nobel de Química en 1958. Con su descubrimiento se demostraba por primera vez de manera concluyente que las proteínas eran sustancias químicas reales y se ponía fin a las teorías anteriores que sugerían que los aminoácidos en las proteínas no tenían ningún tipo de disposición regular. Desde entonces se sabe que los 20 aminoácidos diferentes se alinean constituyendo la estructura primaria de las proteínas.

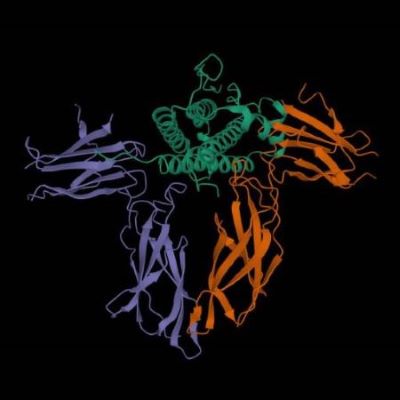

Structure of the protein molecule. Molecular model of human enzyme on a black background.

El segundo paso lo supuso el descubrimiento de la estructura tridimensional del ADN, probablemente el mayor avance científico del siglo XX. En 1953, el americano James Watson y el inglés Francis Crick publicaban sus conclusiones sobre la estructura de la doble hélice, deducida de la interpretación a partir de unas imágenes magníficamente realizadas por Rosalind Franklin, de los espectros de difracción con rayos X de moléculas orientadas.

El tercer paso lo volvió a dar Frederick Sanger con su método didesoxinucleótido (ddNTP) para secuenciar el ADN, que consistía en hacer copias de la molécula a secuenciar e incluir en la mezcla de reacción una de las cuatro bases nucleotídicas marcada y «finalizadora», de tal modo que la síntesis se detiene tras su incorporación y luego se conoce su posición por una electroforesis que separa los productos de reacción por tamaños. Con este extraordinario avance se abría el camino a la lectura del lenguaje de los genes y los genomas, y Sanger recibió un segundo Premio Nobel de Química en 1980.

Estos son los grandes pasos a los que sucederían nuevas metodologías que suponían no solo avanzar en el conocimiento de las dos biomoléculas más importantes de los seres vivos, sino el abaratamiento y aceleración del conocimiento de las secuencias de las mismas en muchos organismos. A finales de los años ochenta, se llegó al Proyecto Genoma Humano, lanzado en 1990 con la perspectiva de dar a conocer la secuencia de los genes y el resto de la información contenida en nuestro genoma. Aunque se previó una duración de varias décadas, se desarrolló de forma fulminante en apenas 13 años, dándose a conocer su culminación en 2003, 50 años después del descubrimiento de la estructura del ADN. A partir de entonces se publicaron en las grandes revistas los detalles del conocimiento de nuestro genoma y de cientos de especies de todos los grupos taxonómicos. Entre los objetivos de este gran proyecto estaban dos muy importantes, que sin duda han facilitado el logro de tan importante conocimiento en un tiempo record: desarrollar una tecnología eficiente para la secuenciación de todo el genoma, y habilitar unas herramientas de bioinformática y estrategias de computación para el uso de los datos de los genes y secuencias.

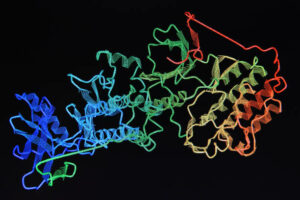

Genetic Science Research as a Medical Abstract Art

Con el Proyecto Genoma se abría la espita hacia nuevas conquistas en el mundo de la Biología digital. Se establecieron las grandes bases de datos para ir acumulando de forma ordenada todo el acumulo de material conocido de todos los genomas que, en el caso del humano, posee más de tres mil doscientos millones de pares de bases nucleotídicas. Se abría paso la búsqueda de los genes en el mar de ADN de los genomas, la comparación de secuencias, estudios de conservación evolutiva de los genes y las proteínas, la deducción de la secuencia de las proteínas a partir de la de los genes, el alineamiento de múltiples secuencias, la deducción de la secuencia secundaria de las proteínas a partir de la sucesión de aminoácidos, etc.

El avance parece imparable. Sin embargo, una dificultad especial era la deducción de la estructura tridimensional de las proteínas. Para descifrar la estructura de las cerca de 170.000 proteínas mapeadas hasta principios de 2022, se habían utilizado potentes técnicas de imagen como la cristalografía de rayos X y la microscopía crioelectrónica. Ahora, en la era de la inteligencia artificial, se imponía el desarrollo de algoritmos que permitiesen conocer la estructura secundaria de cualquier proteína de cualquier especie.

Hay que tener en cuenta que con una misma estructura secundaria podrían darse diferentes estructuras terciarias, o diferentes conformaciones según la función o el entorno de la proteína. Pero, los métodos informáticos permitirían, gracias a la acumulación de datos y al conocimiento de la conformación secundaria de muchas proteínas, hacer predicciones probabilísticas de otras simplemente por comparación. Como los métodos Chou-Fasman y el GOR (Garnier, Osguthorpe y Robson), de finales de los años setenta, que usaban técnicas probabilísticas basadas en datos estadísticos y en el conocimiento de estructuras secundarias comunes en diferentes proteínas.

La solución a la complejidad estructural de las proteínas ha encontrado una nueva vía de resolución en la bioinformática, gracias al desarrollo de las bases de datos que permiten predecir modelos basados en estructuras resueltas previamente como puntos de partida. Este método es efectivo porque, aunque existan varios millones de proteínas diferentes, el conjunto de motivos estructurales terciarios es mucho menos, unos 2000 que se repiten en diferentes proteínas. De este modo, los métodos informáticos pueden sondear las grandes bases de datos y resolver los problemas del modelado de las proteínas por homología o mediante el llamado enhebrado, que contrasta la estructura primaria de una proteína con otras ya resueltas.

Recientemente la todopoderosa plataforma Google ha dado cobijo al programa de inteligencia artificial AlphaFold, del neurocientífico y diseñador de juegos digitales británico Demis Hassabis, que permite predecir las estructuras primaria, secundaria y terciaria de cualquier proteína a partir de la secuencia de bases nucleotídicas del gen que la codifica y por comparación con las proteínas de estructura conocida almacenadas en la base de datos. Utilizando una red informática de 128 procesadores de aprendizaje automático, AlphaFold se centró en primer lugar en las 170.000 proteínas de estructuras conocidas en un proceso reiterativo llamado aprendizaje profundo. El proceso, está inspirado en la forma en cómo procesan la información las redes neuronales del cerebro humano. De este modo, AlphaFold ha aprendido a predecir la estructura física subyacente de una proteína en cuestión de días. El programa es un gran instrumento de predicción en cuanto a su capacidad de análisis y rapidez, y pone en manos de los biólogos moleculares y de la investigación biomédica una herramienta informática de gran valor para deducir cómo son y cómo ejercen su función los millones de proteínas de todos los seres de la naturaleza.

AlphaFold fue presentado a mediados de septiembre en una rueda de prensa a científicos del EMBL (Laboratorio Europeo de Biología Molecular) institución de carácter público que impulsó el desarrollo de la base de datos. Ya el año pasado, otro programa predecesor de AlphaFold, el Deepmind fue capaz de predecir la estructura tridimensional de todas las proteínas humanas. Lo mejor de estos programas es que son de acceso libre y gratuito, siguiendo el rumbo marcado por el Proyecto Genoma Humano,

No obstante, debe tenerse en cuenta que se trata de predicciones, no de deducciones basadas en análisis experimentales. Hay una gran diferencia entre la biología experimental y esta biología digital, que no deja de ser una grandísima herramienta de ayuda a la investigación, pero que no ofrece una certeza absoluta sobre la estructura tridimensional que se desea conocer, pues al fin y al cabo se basa en la deducción por homología de una molécula. Da un modelo, que, dependiendo de los fines que se pretendan con el conocimiento deberá adoptarse con algunas reservas especialmente cuando se desea aplicar en investigaciones biomédicas.

Sin embargo, estamos sin duda en una nueva etapa extraordinariamente útil para el avance en conocimientos básicos y aplicados. Probablemente uno de los campos de aplicación de este tipo de investigaciones esté en el diseño de anticuerpos, vacunas, antibióticos y otros fármacos. Por ejemplo, mediante una de las aplicaciones de AlphaFold se pueden predecir las interacciones entre proteínas de defensa y antígenos bacterianos o de otros agentes infecciosos, basados en la simulación de las interacciones entre las diferentes proteínas. Así, se podrían diseñar nuevas vacunas y fármacos sintéticos dirigidos a todo tipo de proteínas de agentes infecciosos.

Nicolás Jouve de la Barreda es catedrático emérito de Genética, ex miembro del Comité de Bioética de España y presidente de CíViCa.

3

3

0

0